AI惹的祸?已故茶叶专家“复活”带货......

转自:中国消费者报

如今

生成式人工智能(AIGC)技术的飞速发展

让普通人也能仅凭一张图、一句话

实现视频制作

但与此同时

AI视频生成技术滥用风险不容忽视

各种纷杂的人工智能生成信息

常常让人难辨真假

AI视频滥用乱象频发

名人成“被盗用”重灾区

近年来,人工智能技术成熟,AI换脸门槛降低,不法商家利用AI伪造知名人士面容和声音,炮制AI“李鬼”。

10月15日,据“北京市场监管”微信公众号消息,北京市海淀区市场监管局于今年6月查处了某公司利用AI技术冒用央视知名主持人名义和形象的虚假广告案。该公司通过AI技术剪辑知名主持人视频,加入自行设计的口播内容,在自有网络视频账号上以短视频等形式发布普通食品“深海多烯鱼油”广告,宣称“可以解决头晕头痛、手麻脚麻、四肢乏力”等医疗功效,违反了《广告法》相关规定,已被行政处罚。

(央视财经截图)

值得一提的是,这是北京市场监管部门运用《广告法》对滥用AI技术冒用知名人物形象发布虚假广告问题的首次亮剑,释放了明确信号,技术应用不能逾越法律红线。

此案仅是AI技术被滥用的冰山一角

类似闹剧层出不穷

10月14日,已故的著名茶学家、制茶和审评专家张天福被AI工具“复活”为茶企代言一事引发关注。视频发布账号归属福建张天福品牌管理有限公司,工作人员承认,视频系AI制作。

(视频截图)

今年4月,中国国家话剧院发表声明,称发现社会上有公司未经其同意擅自使用话剧《青蛇》作品,违法进行冒演、虚假宣传,滥用AI换脸技术,偷换概念,公开售票,欺骗观众。

此外,某平台一部微短剧被曝疑似使用了AI技术,未经授权将某知名演员的面部特征移植到其他演员脸上,后版权方采取了下架处理,删除了争议片段。

北京社会科学院副研究员王鹏对记者表示,这一现象是技术滥用与流量经济畸形结合的产物,反映了AI技术普惠化进程中创新工具与行骗手段的边界模糊问题,其背后是利益驱动下的伦理失范。

新规落地

AI内容必须“打标”

为什么AI仿冒会出现井喷?

萨摩耶云科技集团AI机器人行业研究员郑扬洋表示,现在可以靠“开源模型+云端API”实现30秒克隆声音和人脸,生产成本比之前低。平台容易给前3秒完播率的权重最高,若把名人带货等内容放在首帧,算法可能会自动放大,这让不法分子尝到了AI换脸的甜头。

面对AI仿冒乱象,9月1日起,国家互联网信息办公室等四部门联合发布的《人工智能生成合成内容标识办法》施行。

《办法》明确要求,利用人工智能技术生成、合成的文本、图片、音频、视频、虚拟场景等信息,必须依法添加相应的声明标识。

根据《办法》,人工智能生成合成内容标识包括显式标识和隐式标识。其中,针对AI生成视频,要求在视频起始画面和视频播放周边的适当位置添加显著的提示标识。

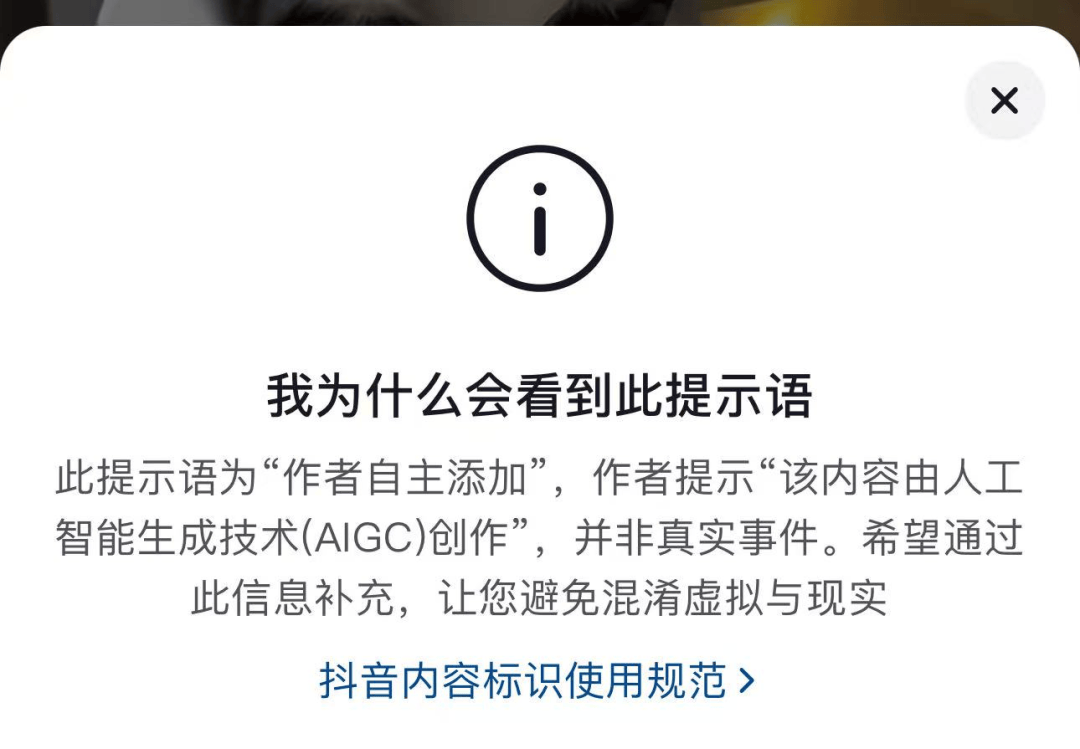

六大平台迅速响应

记者看到,8月29日至9月1日,腾讯、快手、小红书、哔哩哔哩、微博、抖音6家平台均发布公告称已按照相关规定提供AI内容标识声明功能。对于未主动标识的AI生成内容,平台有权添加标识。快手、哔哩哔哩、小红书还在公告中强调用户不得恶意篡改、隐匿平台相关标识。

(抖音平台截图)

但在实际应用中,AI视频标注仍存在诸多难点。用视频模型工具生成的视频,如果用户有心将AI水印进行擦除,平台则存在无法识别AI视频的可能性。一业内人士表示,尽管已有一些AI内容检测技术,但生成模型迭代速度更快,“破绽”修补迅速,检测技术往往处于被动追赶状态,实现百分百精准识别异常困难。

责任模糊、技术滞后

全链条治理待完善

如何减少利用换脸技术侵权的行为?天元律师事务所合伙人李昀锴表示,内容发布平台的责任主要体现在制定明确的平台规则、提供技术或功能支持、履行内容审核义务、采取必要处置措施。如果内容平台未尽到义务,监管部门可以依据《网络安全法》《网络信息内容生态治理规定》等,对平台采取警告、通报批评、责令限期改正、罚款等行政措施。而对于内容发布者而言,目前《办法》实质上没有规定内容发布者不标注的法律责任。实践中,内容平台作为传播渠道,其强制性要求和技术干预是关键。

“部分生成工具具备‘去标识化’功能,可自动擦除平台水印或干扰哈希比对,导致现有监测系统出现漏检。”郑扬洋认为,一个解决方案是端侧硬水印配合链上备案,而非仅靠平台事后删除。

郑扬洋表示,平台可以做降阻前置警告,比如在视频前3秒强制弹窗“本内容含AI生成画面”,红色进度条1秒,降低用户“无意识信谣”。从传播角度看来,既然使用名人来AI生成虚假视频,建议由主流平台与权威媒体共建“AI辟谣”专区,一键跳转可做真伪对比。

郑扬洋对记者表示,现行规范性文件对“训练源头”和“刑事罚则”覆盖仍需要加强,建议需尽快推动人工智能统一立法,把生成、传播、平台责任一并纳入,形成全链条合规指引。